꺼내먹는지식 준

딥러닝 역사, 기본 및 용어 본문

딥러닝의 가장 중요한 역량 3가지

1. 구현 실력

아이디어 구현 능력

2. 수학 능력

선형 대수학, 통계

3. 연구 트랜드를 알기

인공지능이란?

사람의 지능을 모방

머신러닝은 이 중 한 분야

이 내부 중 뉴럴 넷을 사용하는 세부 분야가 딥러닝

딥러닝의 4가지 중요 요소

1. 모델이 학습할 수 있는 Data

ex. 글, 사진 등

2. 모델

ex. RNN CNN MLP

3. Loss function

4. Loss funcion 최소화 algorithm

ex. optimizer (SGD, Ada delta, ADAM)

Data

Classification,

Segmentic segmentation(No objects just pixels 즉 각 이미지의 픽셀별로 분류 dense classification) ,

Detection (Bounding Box),

Pose Estimation (3차원 스켈레톤)

Visual QnA(문장과 사진이 주어졌을 때 답을 구하는 것)

Model

데이터가 주어졌을 때, 성질에 맞춰 결과를 만들어 내는 것

AlexNet 등

Loss

모델이 정해져있을 때 어떻게 학습을 할지

회귀: 보통 MSE

분류: 보통 CE

확률: MLE

결과는 결국 근사치이다. loss function이 주어진다고 원하는 것을 확실히 찾아내는 것은 아니다.

ex. MSE 는 outlier 가 많으면 문제가 생길 수 있다. (다른 테크닉이 필요할 수도)

Optimization Algorithm

주로 1st order method 즉 1차 미분 결과를 활용한다.

SGD 가 잘 동작하지 않아서 momentum adaptive learning을 사용한 알고리즘을 많이 사용한다 .

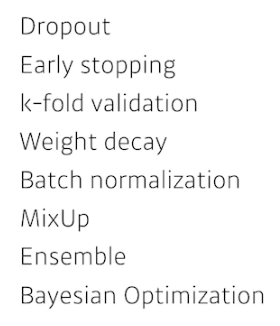

Regulaizer학습이 잘 안되도록 하는 방법론들을 추가하여 학습 하지 않은 동작에서 동작하도록 한다.

ex.

딥러닝의 역사

2020.07.29 Deel Learning's Most Important Ideas 참고 자료

2012 Alex Net (CNN)

224 X 224 사진이 들어왔을 때 분류하는 대회에서 처음으로 일등한 딥러닝 방법론

이 이후로 모든 기계학습 판도가 바뀌었다.

2013 DQN

알파고

2014 Encoder/ Decoder

영어 문장 주어졌을 때(단어 연속), 잘 표현해서 다른 언어의 연속으로 뱉고자 한 것

어떤 백터로 인코딩하고 다른 벡터를 decode 하는 방식

Adam Optimizer

adapative momentum

왜 다 아담을 사용할까?

결과가 잘 나와서이다.

일반적으로 딥러닝 모델들은 하이퍼 파라미터를 계속 바뀌는 것에 따라 결과도 바뀐다. (optimizer 도 그중 하나)

그러나 아담은 웬만하면 잘 되어서 일반인들이 사용하기에 좋다.

2015 GAN

이미지와 텍스를 어떻게 만들어내는지에 관한 모델

네트워크가 Generator , Discriminator 를 통해 결과를 만들어 낸다.

Residual Net

이 연구덕에 "Deep" Learning 이 가능해졌다.

즉, 네트워크를 깊게 쌓을 수 있게 되었다.

레이어를 깊게 쌓을 수 없던 트렌드를 훨씬 더 쌓을 수 있도록 개선시켜주었다. (여전히 1000개는 안되지만)

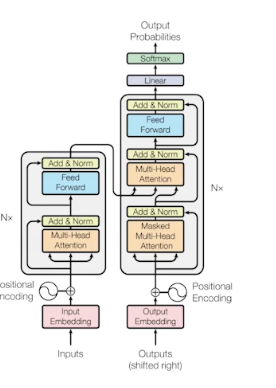

2017 Transformer

Attention is all you need

Attention만 쓰면 된다는 흥미로운 결과였는데 지금은 웬만한 모든 분야에서 많은 모델을 대체하고 있다. 특히 RNN 은 거의 모두 대체

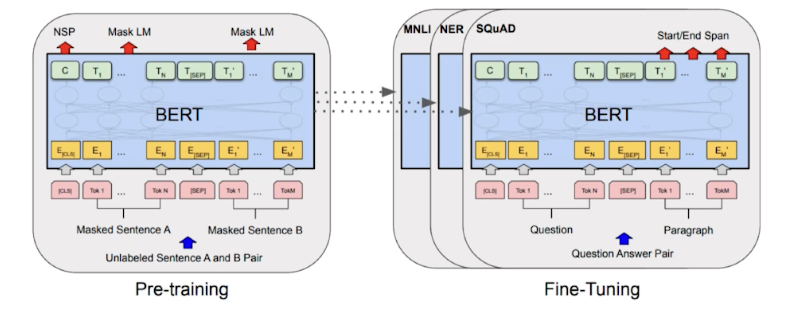

2018 BERT

Transformer 을 사용하지만 Bidirection Encoder 활용

fine tunded NLP Models (자연어에서 language model을 사용한다. NLP 의 다양한 문제를 풀 때 큰 이미 학습된 언어 모델을 사용해서 fine tune 한다.

2019 Big Langauge Models

(GPT3)엄청 큰 langauge model fine tune 을 통해 다양한 것들을 만들 수 있다. 많은 parameter가 특징 1750억개

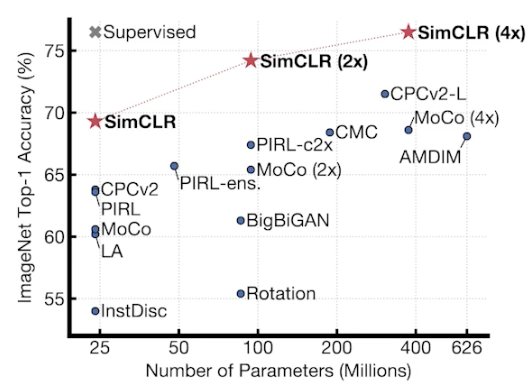

2020 Self Supervised Learning

이미지 분류와 같은 문제를 풀 떄, 학습 데이터가 한정적일 때, 주어진 데이터 외에 라벨이 없는 데이터도 학습에 같이 활용하겠다는 것이다.

어떻게 이미지를 컴퓨터가 잘 이해하는 벡터로 잘 바꾸는지, unsupervised 데이터 셋을 같이 사용해서 우리가 풀고자 하는 문제를 풀려고 하는 것.

'AI > 딥러닝 기초' 카테고리의 다른 글

| Multi layer Perceptron 간단 구현 (0) | 2022.02.07 |

|---|---|

| Neural Net, Multi-layer Perceptron (0) | 2022.02.07 |

| Multi_GPU, 분산 학습, 데이터 병렬화, 파라미터서버 (0) | 2022.01.28 |

| 딥러닝 학습모델 간단 정리 (0) | 2022.01.23 |

| 경사하강법 간단정리 (0) | 2022.01.20 |